阅读:0

听报道

撰文 | 夏志坚

“我们应该发展什么样的人工智能?”,无疑已经成了现在AI开发者和利益相关者最为关注的问题之一。

2019年5月25日,旨在推动中国人工智能研究和技术发展的北京智源人工智能研究院联合北京大学、清华大学、中国科学院自动化研究所等高校和科研机构发布了《人工智能北京共识》。这份关注人工智能研发、使用和治理伦理的文件发布仅两天后,百度上就有多达500万次关于这份中国版的人工智能伦理准则的搜索。

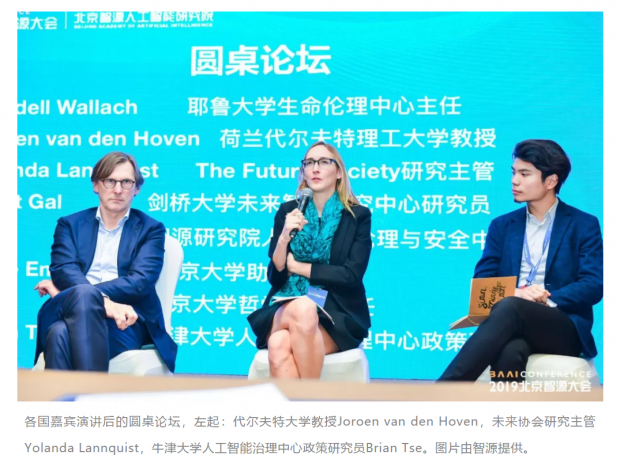

5个多月之后的10月31日,北京智源人工智能研究院在国家会议中心举办了“2019北京智源大会”,在当天下午的“人工智能伦理、安全与治理专题论坛”上,来自欧盟、英国、美国、日本和中国的人工智能领域的专家就人工智能的伦理问题分享了各自的观点。

谁来为AI的后果负责?

耶鲁大学生命伦理中心主任、世界经济论坛人工智能委员会委员Wendell Wallach指出,当前AI发展的一个重要问题是技术的发展速度与相应的伦理发展速度不匹配,以及由此带来的管理上的困境。而要实现高速发展的技术良好运行,“就需要做出更好的预测、更好的规划以及采用更好的处理和管理的方式”。

“我们的科学发现和技术的实现远远快于伦理发展的速度。进一步讲,很少有立法者能够完全了解最新的技术。”Wallach说,“在技术发展的早期阶段进行管理会更加容易,但是在技术发展的早期阶段我们并不知道它会出现什么问题。而当我们发现它会出现一些问题的时候,这个技术已经深入到社会的方方面面,很难再管理了。”

技术的快速发展,在对管理者提出挑战的同时,也对开发者和使用者提出了要求。荷兰代尔夫特理工大学教授、欧盟伦理委员会委员Joroen van den Hoven认为,人工智能的开发者在设计AI的时候,就应当主动思考如何避免问题的发生,并能帮助弱势群体,肩负起“为他人承担责任的一种责任。”

“AI治理是关于为他人承担责任的一种设计。”他说,“我们的设计师要深深地意识到他们的产品是人类选择的结果。”

对于AI的使用者,Hoven强调要避免成为“电脑的奴隶”,避免让AI的判断取代人类自己的判断。“一个技术的使用者必须要负起道德上的责任,才能使用这种智能的技术。如果你不能做出正确的决定,那就不要用它。”他说。

这就要求AI的使用者必须确保他们对AI有充分的了解才能使用。在现实的环境中,倘若AI做了不符合伦理的决定之后,那么应该由谁对这个决定负责?是AI、开发者还是使用者?在不同的国家、不同文化背景的社会,这个问题有着不同的答案:在一些国家,它们认为AI做出的决策是自动的,应该让AI负责任;而在其他国家,AI的开发者和使用者都会负一定的责任。

AI伦理治理的文化差异

“我们必须要考虑文化和社会的不同。不管你使用的是怎样的高端技术,我们需要在背后有一个标准,我们希望技术足够强大,同时也能确保人们以一种正确的方式来使用技术,这是我们的终极目标。”剑桥大学未来智能研究中心研究员Danit Gal说。

“全球分享的这些AI的伦理原则它的理论解释其实是一样的,但是他们在各个国家落实的情况是不一样的。我们有一个全球共享的AI伦理的理念并不意味着每个国家都应该以一种方法来行使这样的技术,每个国家应该考虑自己不同的情况。”Gai补充道。

对待技术的文化差异上,与西方社会形成鲜明对比一个国家便是日本。这个东方国家对待人工智能发展的态度更加宽容和友善:现在日本已经有了机器人酒店、机器人餐厅,甚至虚拟的AI伴侣。

但即使在日本,AI的发展也并不总是令人振奋。AI机器人带来的失业问题,已经在日本引起了很多人的担忧。

“什么样的工作可以被机器取代,什么样的工作不应该被机器取代,这是一个重大的议题,日本正在进行这样的讨论。”东京大学助理教授、日本人工智能学会伦理委员会委员Arise Ema说,“我们需要了解人和机器如何进行更好地互动,我们需要进一步思考如何更好地让机器和人发挥更好的作用。我们现在面临着很多情感的、经济的、社会的、伦理的以及治理性的问题,我们需要进一步思考专家能够发挥怎样的作用,我们是不是能够信任机器?”

对机器的信任归根结底其实是对人的信任,或者是对开发者的信任。这又回到了那个最初的问题:“我们应当发展什么样的人工智能?“

人类价值观的新挑战

从现实的层面来讲,这个问题已经迫在眉睫——在全球化的今天,大型跨国企业让各自的AI系统能够经受不同文化的国家的考验,并不是一件容易的事情,尤其当AI领域的两个大国的竞争正在变得日趋激烈。

“美国和中国在竞争,全球领先的国家以及AI知名的企业都在竞争。我们看到很多的竞争是零和游戏,带来了很大的风险。”未来协会(The Future Society)的研究主管Yolanda Lannquist在演讲中说道。

为了控制这些风险,“我们需要重塑美国、中国以及一些领先的AI公司的模式,让他们彼此合作,而不是彼此竞争。对于顶尖的国家、研究人员和公司,他们需要通力合作,才能治理AI,他们需要确保通过AI来解决我们面临的大挑战。”Lannquist说。

合作便有可能出现价值观的碰撞,无论是人还是机器。

在《人工智能北京共识》发布同一天成立的北京智源人工智能伦理与安全研究中心,此前提出要“开展符合人类伦理道德的智能自主学习模型研究,实现人工智能行为与人类价值观的校准,并在模拟环境与真实场景中进行验证”,然而一个关键的问题是:我们应该让人工智能学习怎样的价值观?对于那些人类自己都难以解决的道德困境,如何让机器做出判断?

10月31日上午,在接受《知识分子》访谈时,中国科学院自动化研究所研究员、智源研究院人工智能伦理与安全中心主任曾毅表示:“人类的价值观并不是统一的,我们看待人类的价值观有不同的视角,而这些视角之间其实不是冲突的,而是对人类之所以成为人类来说是互补的。我觉得人工智能学习的应该是具有统计意义的大多数人认可的人类的价值观,对于像我们遇到的电车难题,这样人类暂时还没有解决的问题,可能还是留给人类首先去讨论清楚,当然如果人工智能发展到了超级智能的阶段,也许人工智能能够辅助人们去解决这个问题。“

曾毅同时表示:“我们其实应该深刻地去反思,如果人工智能在不断地演进演化,我们人类应该做什么?现在有一个词叫做post-human era,后人类时代。人类虽然叫做human being,但从哲学的角度来讲,人类实际上应该叫human becoming,因为人类也是在不断的演化过程当中。所以人类将走向哪个方向,我们对于人类价值观需不需要重新审视,我觉得这是技术的进展对于人类社会的变革提出的新问题。”

话题:

0

推荐

财新博客版权声明:财新博客所发布文章及图片之版权属博主本人及/或相关权利人所有,未经博主及/或相关权利人单独授权,任何网站、平面媒体不得予以转载。财新网对相关媒体的网站信息内容转载授权并不包括财新博客的文章及图片。博客文章均为作者个人观点,不代表财新网的立场和观点。

京公网安备 11010502034662号

京公网安备 11010502034662号