图源:pixabay

撰文 | 吴思

● ● ●

这篇短文不是要讨论今年诺贝尔物理学奖是否不恰当地授予了人工智能专家,而是要澄清授奖对象是否出现了重大遗漏。

John Hopfield和Geoffrey Hinton两位教授获得了今年的诺贝尔物理学奖,其中Hopfield教授的获奖原因是因为发展了著名的Hopfield吸引子网络模型。由于我长期在做有点冷门的吸引子网络的理论研究(见微信公众号文章【学术思想】连续吸引子神经网络:神经信息表达的正则化网络模型),因此不少同事祝贺我,有种终于 “苦尽甘来”,可以“与荣有焉”了的感觉。但我内心却是五味杂陈,因为我深知道Hopfield模型背后真实的故事。有朋友鼓励我说,为计算神经科学领域外的读者以及年轻学者计,我应该写下这段公案,给历史留一段记录。

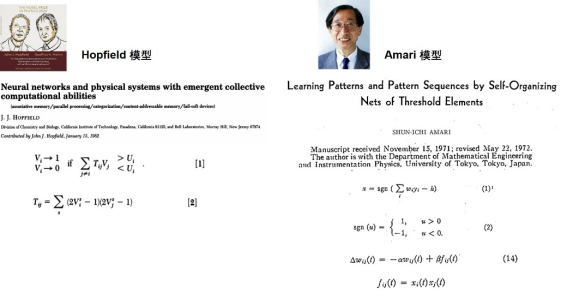

简单说就是,日本著名科学家Shun-ichi Amari(甘利俊一)教授在1972年就已经提出了Hopfield教授在1982年发表的Hopfield模型,前者比后者整整早了十年。两个数学模型几乎一模一样,而且Amari教授的文章还做了更深入细致的数学分析。图1简单对比了两个模型的最关键相同之处,包括神经元的阈值动力学(threshold dynamics)和神经元连接的Hebbian 学习律。基于该数学模型,两篇文章都分析了网络动力学的稳定状态,即吸引子,并由此引申到了大脑的联想式记忆。读者可以仔细对比Amari1972年[1]和Hopfield 1982年[2]的文章。有科研经验的读者都知道,在模型如此相似的情况下,有了Amari 1972年的文章,Hopfield 1982年的文章其实很难能发表在重要杂志上了。当然在当时资讯条件下,有可能Hopfield教授并不知道Amari教授的工作。

图1:Amari原始模型和Hopfield原始模型的对比。两者的数学形式几乎是一模一样的,都采用了神经元的阈值动力学和神经元之间连接的Hebbian学习律。

在计算神经科学及相关领域,Amari教授比Hopfield教授早十年提出Hopfield模型并不是一个鲜为人知的秘密,而是一个很多人都知道的事实。计算神经科学领域的著名学者Haim Sompolinsky教授(2023年Brain Prize大奖的获得者)在一篇文章中曾评论到:“虽然Amari更早提出了一样的模型,但因为Hopfield贡献很大,所以我们叫它Hopfield模型“,英文参见[3]。计算神经科学领域另一位已过世的著名学者Daniel Amit(《Modelling Brain Function: The World of Attractor Neural Networks》书的作者)曾经当面给Amari教授道歉,表示这是学术界的一个错误,该模型应该叫Amari-Hopfield模型,并赠予了Amari教授一条红色领带作为歉意。

诚如Amit教授所言,在当年资讯远远落后于今天的时代,即便是Hopfield教授独立发展了该模型,出于科学惯例,这个模型也应该叫Amari-Hopfield模型更合适。但让人费解的是,诺贝尔奖评审委员会在明知Amari教授早期工作的情况下(诺奖的科学背景介绍还列出了Amari1972年的文章),依然忽视了Amari教授的贡献,实在是让人难以理解。

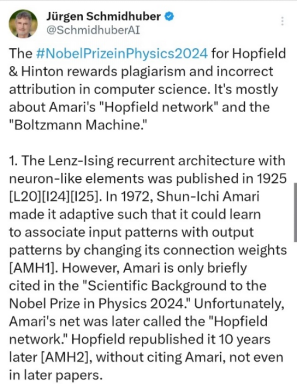

需要申明的是,我介绍这段历史并不全因为我是Amari教授的弟子,有为老师发声之嫌。其实在外网的一些论坛上,对此争论更激烈。著名的德国科学家Jurgen Schmidhurber教授(LSTM模型的发明人)就在一个有悠久历史的邮件群connectionist里为Amari教授的不公发声。摘录部分如下:

图2:Schmidhurber教授对Amari模型早于Hopfield工作10年的评论。

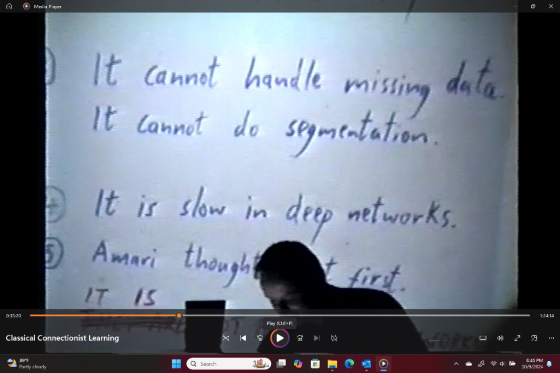

可能有读者知道,Schmidhurber教授在其它场合也为另一段公案发声,其涉及到了Amari教授在人工神经网络最基础的训练算法-反传算法(BackProp)上的重要贡献,我这里也介绍一下。简单说就是,Amari教授在1967年就提出了stochastic gradient descent(SGD)(但由于当时计算机算力受限,只在浅层神经网络上做了演示)[4],比Hinton教授等人提出的有相似思想的BackProp(1986)[5]早了19年。当然我本人特别崇敬Hinton教授,尤其佩服他锲而不舍地把基于深度学习的人工智能技术推广到了今天的高度,但在BackProp的优先权上还是应该一码归一码。有好事者在connectionist群里发布了一张Hinton教授在1997年ICNN会议上介绍BackProp的照片,演讲题目是“What’s wrong with Backprop?”, 其中Hinton教授本人写下了“Amari thought it first” (见下)。

图3:Hinton教授在ICNN1997会议的演讲稿,其中写下了Amari第一个想到BackProp。

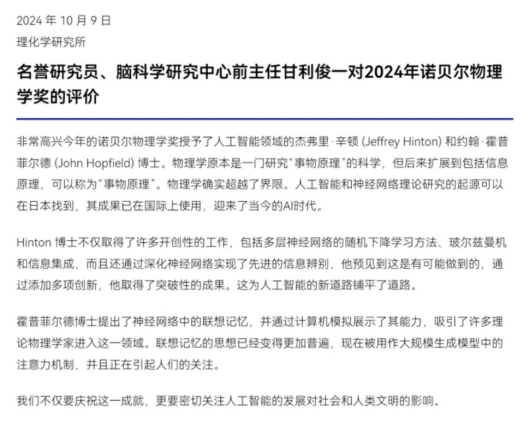

在诺贝尔物理学发布之后,Amari教授很快就在日本理化学所的官网上发表了公开声明(见图4),其间只字未提自己的不公,反而真诚地祝贺了两位获奖者,体现了Amari教授一贯淡泊名利、与世无争的风格。但作为知情者,我认为不能因为Amari教授的高风亮节,我们就默认这种行为是无所谓的,其后果只会破坏科学共同体赖以健康发展的基石。

Amari教授一生在科学上建树太多,有兴趣的读者可以参见Amari教授回顾其在计算神经科学领域半个世纪工作的文章[3]。除了上面提到的吸引子网络、BackProp,还有一项在我看来理论上更漂亮的工作是信息几何(information geometry)。该工作用微分几何方法分析了数据驱动的模型学习的本质,是对模型学习机理最深刻的认识。因此,我虽心有怅然,但我坚信,没有诺奖或图灵奖的加持,Amari教授在科学上的巨大贡献也一样流芳百世!

图4:Amari教授在诺奖结果公布后,很快就在日本理化学研究所官网上发表的公开声明(中文翻译稿)。

后记

最后我也向感兴趣的读者简单介绍一下吸引子网络的后续发展。在AI领域,Amari-Hopfield模型近年来被推广为了modern Hopfield模型[6]。在神经科学领域,Amari-Hopfield模型逐渐被其它生物学更合理的吸引子模型代替。当前最热的吸引子网络模型是连续吸引子网络(CANN)(参见微信公众号介绍文章【学术思想】连续吸引子神经网络:神经信息表达的正则化网络模型)。特别值得指出的是,Amari教授在1977年就发表一篇纯粹基于数学性质考虑的CANN模型[7],远远走在了实验证据的前面[8-9],也是领域内的一篇经典工作。作者在Amari教授实验室做博士后期间,和Amari教授一起发展了一个理论可解的CANN模型[10],并在随后的二十多年里围绕该模型开展研究。近年来,作者课题组进一步推广了该模型,在动力学方程中引入了适应性反应(adaptation),以解决吸引子网络面临的一个根本性难题:一方面,吸引子使得大脑可以稳定表征信息;但另一方面,其也不可避免地带来了副作用,即一旦神经系统进入了一个吸引子状态,就很难脱离该状态,使得大脑难以实现信息的快速迭代或搜索。通过在吸引子网络中引入时程相对较慢的适应性动力学(其可以被神经系统中广泛存在的副反馈作用实现),就能使神经系统既可以稳定地表征信息,同时又能快速搜索或迭代信息。我们系统分析该模型的计算性质[11-12],并用该模型成功了解释大量的神经生物学现象[13-14]。

本文作者吴思系北京大学心理与认知科学学院教授,麦戈文脑科学所常务副所长

参考文献:

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号