撰文 | 华 夏

责编 | 陈晓雪

在新冠疫情期间,许多新技术被投入疫情防控中,包括能在戴口罩情形下使用的 AI 面部识别技术,AI 增强的红外体温检测等,这些新技术应用能帮助有关部门定位病毒密切接触者的行踪,也能帮助社区和公共场所对进出人员的身份进行验证与管理。与此同时,这些技术的应用往往会涉及到对公众个人隐私信息的收集和使用。

然而,公众是否认同这些新技术的使用?AI 技术在应用时,其数据隐私安全是否规范,公众是否有途径管理自己的隐私数据?这些问题亟待讨论。

5月17日,由北京智源人工智能研究院人工智能伦理与安全研究中心和中国科学院自动化研究所中英人工智能伦理与治理研究中心联合完成的《人工智能与健康社会系列调研报告》第一期上线,这份关于人脸识别与公共卫生的报告,探讨了公众对人脸识别等检测技术在新冠疫情期间和疫情结束后进行使用的态度。

该报告使用了一千余份在线问卷调查的结果。报告显示,受访者普遍认可人脸识别技术在公共卫生安全中的作用,但也普遍关心人脸识别的隐私问题,且多数受访者希望在疫情带来的”公共卫生危机“状态结束后,减少相关技术的使用。研究者认为,“在安全问题突出时,人脸识别技术应用易被接受;当安全问题不突出时,隐私问题则相对更被关注”。

目前我国和世界范围内针对 AI 技术应用的数据安全和隐私保护的现状如何?为什么我们需要在意个人数据安全?应该如何平衡社会安全的收益和所付出的个人隐私代价?

就以上问题,《知识分子》专访了北京智源人工智能研究院人工智能伦理与安全研究中心主任,中国科学院自动化研究所曾毅研究员和研究工程师鲁恩萌。

曾毅指出,大多数受访者有数据隐私保护需求的,他们愿意去知道自己的数据是否安全,储存在何处,由谁管理。对于AI和其他基于个人用户收集和利用的技术,不能因为新冠疫情这样的紧急公共卫生问题,以至不做伦理与安全评估就上线。目前,我国针对 AI伦理与治理方面的原则、规范大多尚停留在软性的倡导和建议层面,AI伦理与个人隐私数据立法方面的工作未来还有很长的路要走。未来,应该鼓励关于社会安全和个人隐私如何平衡的公开探讨。

以下是访谈全文:

知识分子:你们最近做了一份人脸识别与公共卫生的调查报告。为什么要做这样一个研究?

曾毅:我们这个报告你可能有注意到一个细节,它的副标题叫做 “人工智能与健康社会系列调研”。这里的 “健康” 不光是指身体上的健康,也包括整个社会能够向积极的、可持续的未来发展。我们希望能通过一系列的人工智能与健康社会的调研,推动人工智能向对社会有益的方向发展。

人工智能应用的场景是非常丰富的,但有些应用对社会长期来讲不一定有益处。比如在教室里安装监控摄像头监控每一个学生是不是认真上课,这种应用的商机非常大,但是它可能对下一代产生了很负面的影响。例如这种技术改变了本应由教师与学生深度互动相互理解的交互方式,技术目前的缺陷,导致对于表情识别与预测结果的准确性仍不具备十足的把握,基于此对学生状态的推测更不具备扎实的技术基础。更关键的是可能使下一代对人工智能技术产生强烈的抵触情绪。

人工智能的从业者可能会被短期利益驱动,或者只是为了满足个人的好奇心,或者是为了产生颠覆性的变革,而进行各种利用人工智能的尝试。但是这些尝试可能会产生或好或坏的影响,这种(影响负面的)事情是很普遍的,不只是我刚才举的一个例子。

我们希望通过问卷调查与分析反映公众对这一主题的关注与思考。促进人脸识别在公共卫生领域相关研发、应用、部署、使用环节对科技伦理与治理的关注。另一方面也希望通过公众的反馈,给人工智能从业者一些反思:社会所需要的人工智能是什么样的,我们开发的人工智能应该是什么样的?人工智能研发者对于技术发展的认识,与社会对人工智能的期待,是不是匹配的?

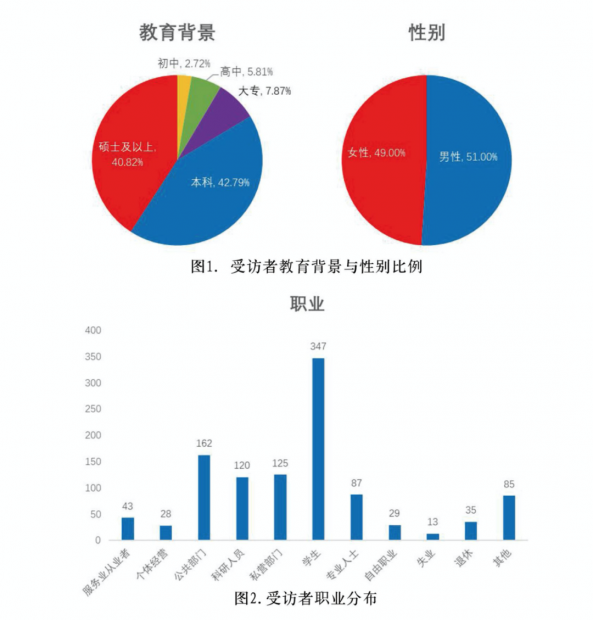

报告中受访者教育背景与性别比例,及职业分布。

知识分子:这个研究的规模将会有多大呢?报告中受访对象本科和硕士学历占比超过 80%,这比起中国的平均水平高得太多了,而目前我国人口中拥有本科学历占比不到 4% 。你们计划在未来扩大采访对象的范围吗?

曾毅:我觉得第一次的规模不大不小,调研对象大概1100多人,已经有一定的代表性。很多AI 方面的调查规模在几百人左右。

这次主要是通过北京智源人工智能研究院相关的一些平台,以及微信朋友圈进行传播。在我们能够构造的调研范围中,确实学历水平会比较高。另外限于人工智能技术本身的门槛, 其实对它需要有一些了解,对它潜在风险问题的认识才会比较凸显。所以可能有本科的教育的话,他的回答会相对客观一些,针对这次调研而言,可能更具参考价值。

人工智能对于社会的影响显然不只局限在有本科学历的群体。这次调研的职业差异和教育背景差异,其实分布得不是太均匀,以学生,科研人员和企事业机关工作人员为主,这方面未来应该会做改进。另外我想针对这个系列调研来说,被调研的对象应当更多的是被人工智能相关服务直接影响到的群体。

知识分子:这项研究预计会产生怎样的结果呢?会直接导向政策制定吗?

曾毅:这项研究的分析结果首先反映的是公众对于人脸识别与公共卫生危机之间关系的认知。我想相关结果对于相关政策的制定应当有一定的参考价值。另外它的价值应不仅仅体现在对政策制定的参考价值,我们甚至更期待相关的人工智能企业等创新群体能够针对公众的反馈与意见,对未来如何从事负责任的人工智能创业创新有更深刻的认知。

疫情暴发以来,无论是中国相关部委、还是世界卫生组织、联合国相关机构,都针对新冠期间数据处理与人工智能相关应用颁布了相关规范。在疫情期间,人工智能的伦理和治理的问题会更加凸显,但这并不是一个借口,让我们可以放宽对于人工智能伦理的要求。举个例子,全世界接近两百个国家中,有三分之一到二分之一,发布了关于新冠肺炎期间数据隐私的政策。所以新冠的流行并没有使其他国家无暇顾及数据采集和人工智能潜在的伦理安全问题。

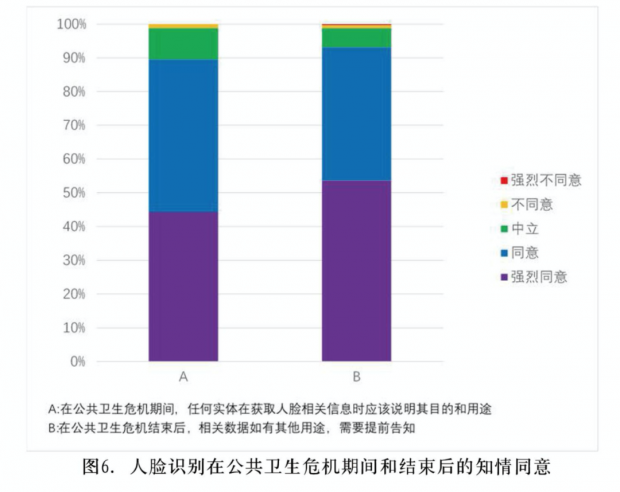

我们做完调研得到一个重要结论是:绝大多数公众希望社会能够回到常态。所谓的常态,就是说不能让社会未来维持这么多的监控摄像头,天天都要测体温,等等。现在有些部门颁布的指南里也有写到:疫情期间收集的数据,未来不能用作其他任务,除非是用于严格控制的研究,或者有额外的用户知情同意,否则这些数据不能以任何形式进行不合理的使用。

知识分子:这份调研报告的 4.2 部分提到,有超过九成的受访者认为自己应该有权知道哪些实体拥有自己的数据,但约六成的受访者不清楚自己数据的实际拥有者是谁,且也只有约三成的受访者认为自己的面部数据当前是安全的。这似乎说明民众对面部数据的掌控能力是十分有限的?

曾毅:对,人脸识别的应用在绝大多数场景下,应该是要做提前的用户知情同意的。虽然各部委会有一些规定,但是绝大多数明确约束的是相关的企业。但是人脸相关的数据,很多是被政府用于社会安全相关的目的。政府掌握哪些数据,特别是人脸识别的数据采集,出于很多原因,目前没有也很难做到对公众完全公开。

从人工智能长远发展来讲,不管是企业还是政府,应当就一部分的信息进行逐步的透明化,或者至少增强公众在这个方面的认知。你也可以看到,我们公众有这方面需求的,他愿意去知道,他觉得有必要知道。

所以现状确实不是最理想的状态,未来改进的空间是巨大的。这不光是对中国的挑战,我想对各个国家都是一样的,并不是说世界上有一个国家在这方面可以做到百分之百的透明。

绝大多数受访者表现出了获得个人隐私数据使用的知情同意的强烈意愿

知识分子:目前关于人脸数据的收集还有一个情况,就是大大小小的有关部门,比如交通部门,医疗系统,甚至社区居委会都在收集公众的数据。但是在疫情结束之后,有什么办法能够让我去管理这些数据呢?我作为一个个体,如果想知道到底哪些人拥有我的数据,有什么办法吗?

曾毅:对于普通的公众来讲,目前还没有相关的渠道去掌握哪些数据被哪些部门拥有。

如何去提高用户的知情权?哪些地方有我的数据?我是不是授权他使用?我能不能让他删除?现在都不是很明确。但明确的是,用户和公众有这种需求。所以各种利用个人隐私数据的应用,未来都存在着去改进的空间。企业有责任,政府也有责任。

知识分子:你怎么评价当前各政府部门对数据的保护意识和能力?他们能不能保护好公众的数据?

曾毅:现在政府会委托一些企业来做 AI 应用系统,很多的企业做人脸识别算法做得很好,但是他们做数据库安全(database security),就不一定会有完善的机制。

现在可以看到一些做人脸识别的公司会跟信息安全公司去合作,去做后台的解决方案。但目前我们不能确信所有政府部门的应用,都有相对完善的隐私保护机制。像去年的杭州人脸识别第一案,讨论刷脸的数据是储存在于动物园管理部门还是储存在 AI 公司,数据安全这块是由谁来保障的。我想很多时候答案未必十分明确。

杭州野生动物园人脸识别第一案,使得公众去开始去关注,原来采集人脸的数据系统背后可能是不安全的。类似的事件,比如说19年2月份的时候,有国外黑客发现,250万条个人隐私相关的数据在互联网上被公开。你只要有一个浏览器,就可以访问到他人的隐私数据。这个应用程序是公司给政府做的。你可以看到,承担相关研发工作的公司并没有合格的资质来确保公众隐私数据的安全,而政府部门也没有对相关公司提出有效的约束机制。

我想,对这样的问题不能都是事情出来了以后,再去讨论补救的措施,而是应该在应用上马之前,就要做好保护机制和安全系统。

知识分子:当下的一个困难是在疫情这种紧急情况下,似乎不可避免的会紧急上马各种并不完善的新技术项目。比如说杭州健康码刚开始推行的时候,杭州市政府接到大量市民投诉。他们很困惑,因为他们的健康码变红了,但是和他们一直住在一起的家人健康码却是正常的绿色。在公众反映问题之后,当地政府也确实是改正了判断结果。这种情况下如何去做好安全机制呢?

曾毅:现在人工智能的公司,包括应用的提供商,它的(管理)结构是不完善的。很多 IT 巨头企业,其实在它们的内部都有 AI 的安全和伦理的委员会,或者是工作组。相对来说能够更好的确保他们上线的产品的安全性。比如微软就有一个检查列表(checklist),产品在上线之前,关于它的安全和伦理问题,是需要去一条一条的去检查的。

但是国内的公司恐怕不是这样。国内有这样的机制的公司,你一只手是可以数出来的。并不是说国内的公司不好,但改进的空间的确很大。

知识分子:你们的报告里提到,疫情相关的 AI 系统使用,存在一个安全和隐私的平衡,似乎如果我们需要绝对的安全,就要牺牲很多隐私,反过来如果我们要很多隐私,就无法保证安全。针对这个问题,有没有一个更系统性的框架,去具体地衡量到底我牺牲了多少的隐私,换来了多少安全?

曾毅:我觉得其实我们从两个方面来谈这个问题。

第一个是你牺牲了多少隐私,获得了多少服务,这是一个角度。第二个是你牺牲多少隐私,换来了多少社会和个人的安全。

很多人工智能应用当中,他是以牺牲隐私为前提提供给你服务的。比如说收集很多的个人数据可以给你做个性化服务的推荐,包括职业的推荐,买东西的推荐,甚至是朋友的推荐等等。但是他的大前提都是对你个人隐私数据的分析与利用。如果你不牺牲个人隐私,你就享受不到相关的服务。这种情况下,决定权利主要是在用户个人的手里。

但绝大多数用户选择的是我不去读知情同意,反正我要用这个软件,反正我要交朋友,反正我要你给我推荐好的东西,所以我就答应了。这需要督促公众有这方面的认知。他要去看,仔细的看,不合规就不能随意同意。

另一面,是隐私数据的采集跟社会安全的平衡。我觉得现在的做法下,很难达到理性的权衡。现在绝大多数情况是大规模,大范围的部署 AI 系统,以避免出现紧急情况。理论上,你部署的越多的摄像头,人脸识别的技术的存在,那么被遗漏的死角越少,但隐私就越不容易被保护。

现在的解决方案是倾向于,一旦可能有安全风险,那么这件事情我们就可就去做,也许无可避免牺牲掉了绝大多数人的隐私, 来确保潜在的社会危机不要发生。

这在国际上其实也处于一个非常不确定(uncertain)的状态。虽然说国际上可能会批评这样做没有人权,侵犯隐私,但是你可以看到由于相关技术的部署,确实降低了犯罪率,确实避免了很多社会危机。

所以我觉得应该更多的公开讨论如何平衡安全和隐私,但是目前没有好的解决方法。

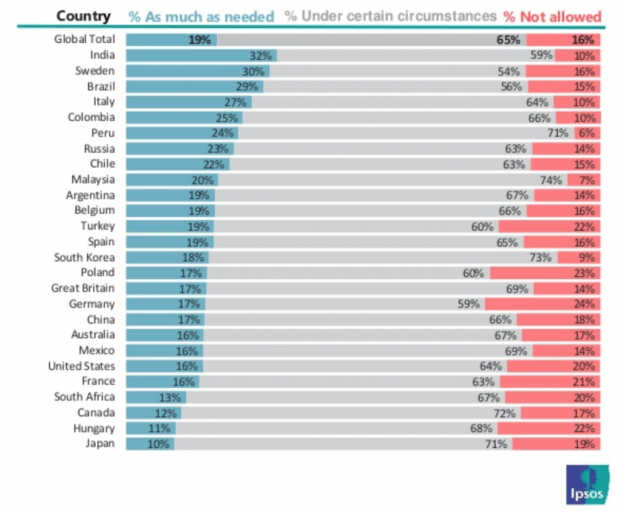

鲁恩萌:其实从各个国家民众的调研报告,例如2019年市场研究公司益普索(Ipsos)进行的调查来看,有超过三分之二的民众是支持政府出于社会安全的原因收集公众隐私数据的。

报告问题大致是说,“你对于政府对面部识别技术在特定情况下的使用是不是支持?” 几乎是所有的国家的大多数用户,其实是支持的。比如说像中国 82% 的民众支持政府,美国是 80% 左右。

市场研究公司 Ipsos 在各国进行的关于公众对政府使用AI和人脸识别技术的态度报告

知识分子:但是这个“特定情况下“是如何定义的呢?因为其实比如你们的这份报告中提到,其实只有百分之三十几的受访对象认为自己数据是安全的……

曾毅:你刚才说这个问题,虽然报告上好像看上去大家比例差不多,但是每一个国家的民众在定义什么叫做政府“在特定情况下的正当使用”,可能是完全不一样的解读。

如果你追加问题:政府是不是真正能保护你的数据安全?在这种情况下,你再让他去回答你,是不是同意政府使用你的数据,结果可能会很不一样。

知识分子:我作为普通民众可能会觉得, 其实我的人脸照片也不是那么难获取,如果我在走在街上,你拍了一张我的照片,好像也没什么大不了嘛?何况我们还在主动地上传大量自拍到社交网站。面部数据如果泄露了,它就可能会造成比较严重的后果是什么?

曾毅:人工智能数据泄露的风险,跟照片照相的风险,差别在于人工智能可以 “把你所有的个人数据互相关联来理解你(associate all your personal data together to understand you)”。

鲁恩萌:像指纹、人脸,都是属于永久性的数据,不像密码泄露后,你可以再改个密码。人脸信息一旦丢失之后,你的面部数据被滥用的话,但你却很难因此去整容。

虽然你可能觉得,别人获得了你的面部数据在当前不重要,但是随着未来人脸识别技术的推广,可能会有更多的应用,不只是用来支付,解锁手机等等。你现在无法预测未来他们会拿人脸信息去做应用。所以你现在一旦面部信息丢失了,那么之后任何基于的你的人脸信息的相关技术应用,对你来讲都是有风险的,

曾毅:而且现在已经有这样的人工智能技术,根据一张二维的照片,它可以三维重构一个立体的人脸出来。现在二维的图像已经过不了一些应用的人脸识别了,但如果能通过二维图像做出来一个三维的人脸的模型,那么面部数据泄露潜在的风险就更大了。

知识分子:你觉得目前疫情期间使用的 AI 技术,是否有过度使用的地方?比方说,现在即便你戴着口罩,AI 通过眼睛和眉毛的特征,也可以识别出你的身份。但真的有升级这项技术的必要性码?如果真的要对我进行面部识别,我也可以暂时摘一下口罩嘛。

曾毅:我们理解大家在逼近技术极限的尝试。并且在疫情的期间,你不能够说有戴口罩的人脸识别的系统,它是绝对没有用的。

但是确实有非常多的人表示了担忧。恐怕绝大多数的时候,不一定非要通过戴口罩的人脸识别技术来识别出你的身份。对病毒接触者的追踪,人脸不是唯一的手段,甚至不是最准确的手段,比如你的物理的定位也可以通过手机信号来确定。

另一方面,这种尝试反而可能会带来新的风险。例如,AI 应用在降低识别门槛。在训练的过程,我不用看你鼻子,不看你嘴,也能够训练一个模型,即便你带着口罩也可以去解锁你的手机了。但是这样的话,因为用到的脸部信息更少,它会更容易被攻破,带来更多的安全的隐患。

另外,因为有时候人们选择戴口罩的时候,他的目的不一定是做坏事,他可能只是不希望大家认出他,比如说明星,对吧?他戴上口罩,别人不认识他了,但人工智能可以做到。在机场你一待,马上用人工智能应用一照,是哪个明星,人工智能比人识别得还要准。你说这种技术会不会被误用?

所以这个线划在哪儿,我觉得确实需要去商榷。

知识分子:现在是否有 AI 安全和伦理方面的国家标准,或者说实践上大家都必须遵守的规范吗?

曾毅:目前是没有上升到法律的层面。像我们发布的一些伦理原则,去年发布的《人工智能北京共识》,包括科技部《新一代人工智能治理原则》,这些其实都是伦理与治理原则。它是软的,不是硬的。目前相关部门也在酝酿这些原则的落实机制。

好的趋势是,现在有相关的人工智能公司在考虑在自己内部成立人工智能的伦理委员会,但是现在这个事情还没有成为一个人工智能企业的普遍认知。

人工智能伦理应当贯穿于研发、设计、部署、使用等整个人工智能产品与服务的生命周期中。对于很多中小企业而言,建立自己的人工智能伦理委员会和团队,短期内不一定可以全部落地。国家应当鼓励推动人工智能伦理与治理公共服务体系与平台的形成。

我相信不同的科研机构、企业、乃至AI服务的用户都会受益于此。太多的实例证明,缺乏AI安全与伦理的评估,使得很多企业推出的AI相关产品在服务于社会时产生了不可预期的摩擦与隐患,所以对未来人工智能的创新企业,或者大数据驱动的创新企业,需要提出一个新的要求:对于技术系统可能带来的社会隐患,恐怕是再急着上马的项目,也不能不做安全和伦理的评估就上线了。

在人工智能的伦理和治理里有一个叫做 “多方利益相关者责任”(multi-stakeholder responsibility)的说法。企业应该应该根据国家和国际公布的一些原则,以及自己的伦理和道德委员会,去进行自我审查。而政府应该有相关的监管机制。不光是政策的出台,也应该有相关的监管机构和推动AI伦理与治理的服务机构。

目前,我们国家正在建设的新一代人工智能创新示范区。我们就在建议,应该在这种创新示范区里,率先建立这种人工智能的治理机制和平台,来保证创新企业发布相关服务时,不只是事前,而是在整个人工智能产品的生命周期中,都能贯穿对相关风险的思考,在可获知存在潜在风险的时候,能够及时进行监管和治理。

0

推荐

京公网安备 11010502034662号

京公网安备 11010502034662号